Was ist das AI-Alignment-Forum?

Das AI-Alignment-Forum ist eine Website, die JavaScript benötigt, um ordnungsgemäß zu funktionieren. Es ist eine Plattform für die Diskussion von AI-Alignment, einem wichtigen Aspekt der künstlichen Intelligenzforschung, der sich auf die Gewährleistung von AI-Systemen richtet, die mit menschlichen Werten und Zielen ausgerichtet sind.

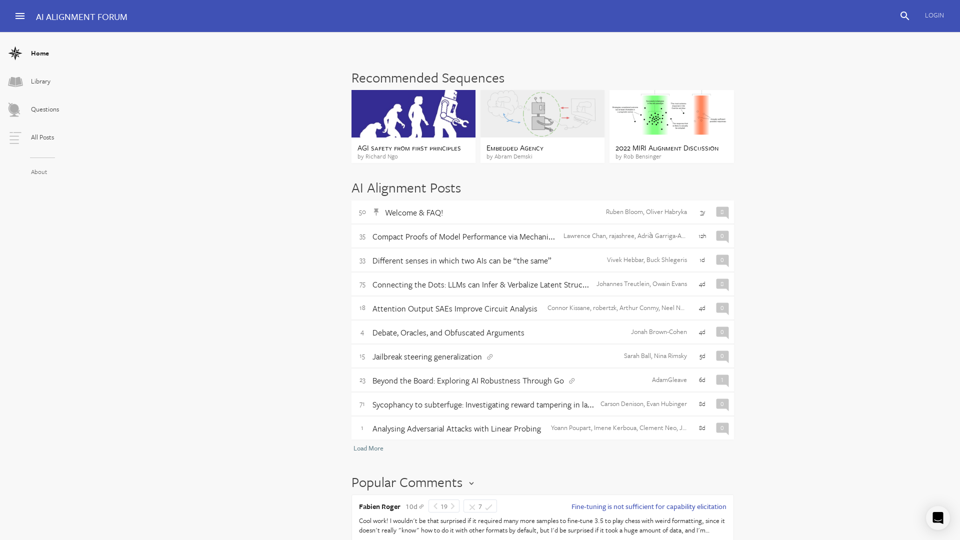

Merkmale des AI-Alignment-Forums

Das Forum verfügt über verschiedene Abschnitte, darunter: *

Bibliothek: Eine Sammlung von Artikeln, Papieren und Ressourcen zum Thema AI-Alignment.

Fragen: Ein Abschnitt, in dem Benutzer Fragen stellen und beantworten können, die mit AI-Alignment in Zusammenhang stehen.

Alle Beiträge: Eine Feed aller Beiträge auf dem Forum, einschließlich Artikel, Diskussionen und Kommentaren.

Empfohlene Sequenzen: Eine kuratierte Liste von Beiträgen und Artikeln zu bestimmten Themen im Zusammenhang mit AI-Alignment.

Beliebte Diskussionen auf dem AI-Alignment-Forum

Einige beliebte Diskussionen auf dem Forum umfassen: *

Sicherheit von künstlicher allgemeiner Intelligenz (AGI) aus erster Prinzipien: Eine Diskussion über die Sicherheit von AGI-Systemen.

Sicherheit ist keine Sicherheit ohne soziales Modell: Eine Diskussion über die Bedeutung des sozialen Modells in der AI-Sicherheitsforschung.

Korrigibilitätseinstellung: Eine Diskussion über den Begriff der Korrigibilität in AI-Systemen, der sich auf die Fähigkeit eines AI-Systems bezieht, von Menschen korrigiert oder geändert zu werden.

Schlüsselbegriffe in der AI-Alignment-Forschung

Einige Schlüsselbegriffe in der AI-Alignment-Forschung umfassen: *

Korrigibilität: Die Fähigkeit eines AI-Systems, von Menschen korrigiert oder geändert zu werden.

Werteausrichtung: Der Prozess, bei dem AI-Systeme mit menschlichen Werten und Zielen ausgerichtet werden.

Gegenspielerisiken: Risiken, die mit AI-Systemen verbunden sind, die als Gegenspieler oder Täuscher konzipiert sind.

Sicherheitsfälle: Eine Methode, um die Sicherheit von AI-Systemen zu gewährleisten, indem potenzielle Risiken identifiziert und gemindert werden.

Bedeutung von AI-Alignment

Die AI-Alignment ist ein kritischer Aspekt der AI-Forschung, da sie sichergestellt, dass AI-Systeme so entworfen werden, dass sie dem Menschen nützen und potenzielle Risiken vermeiden. Die Bedeutung von AI-Alignment kann nicht genug betont werden, da sie das Potenzial hat, verschiedene Aspekte der Gesellschaft zu beeinflussen, einschließlich Wirtschaft, Gesundheit, Bildung und nationaler Sicherheit.